Les Large Language Models (LLM) ont ouvert de nouvelles perspectives pour concevoir des agents conversationnels capables de traiter et générer du langage naturel de manière de plus en plus performante. Cependant, lorsque l’on parle de création d’agents spécialisés, la question se pose : faut-il entraîner son propre LLM ? Ou est-il parfois plus judicieux de s’appuyer sur un modèle générique, éventuellement “augmenté” par des mécanismes de récupération d’information ?

Dans cet article, nous allons explorer les différents niveaux de “spécialisation” possibles pour un LLM. Nous verrons que chaque degré de spécialisation a ses avantages et ses inconvénients, et qu’il n’y a pas de solution unique qui surpasse toutes les autres.

1. Pas de spécialisation

Il s’agit de l’utilisation d’un modèle LLM générique sans mécanisme d’augmentation du contexte ni modification des poids.

POUR

- C’est clairement la solution la plus simple, qui ne présente aucun coût hors celui des requêtes (prompts) envoyées à l’API du LLM.

- Le modèle, pré-entraîné sur d’immenses corpus, sait déjà répondre à une grande variété de questions générales.

CONTRE

- Les réponses seront limitées à la connaissance générique du LLM au moment de son entraînement.

- Si le domaine d’expertise de l’agent est très spécifique, on risque d’obtenir des réponses incomplètes ou peu précises, faute d’avoir été entraîné sur ce secteur.

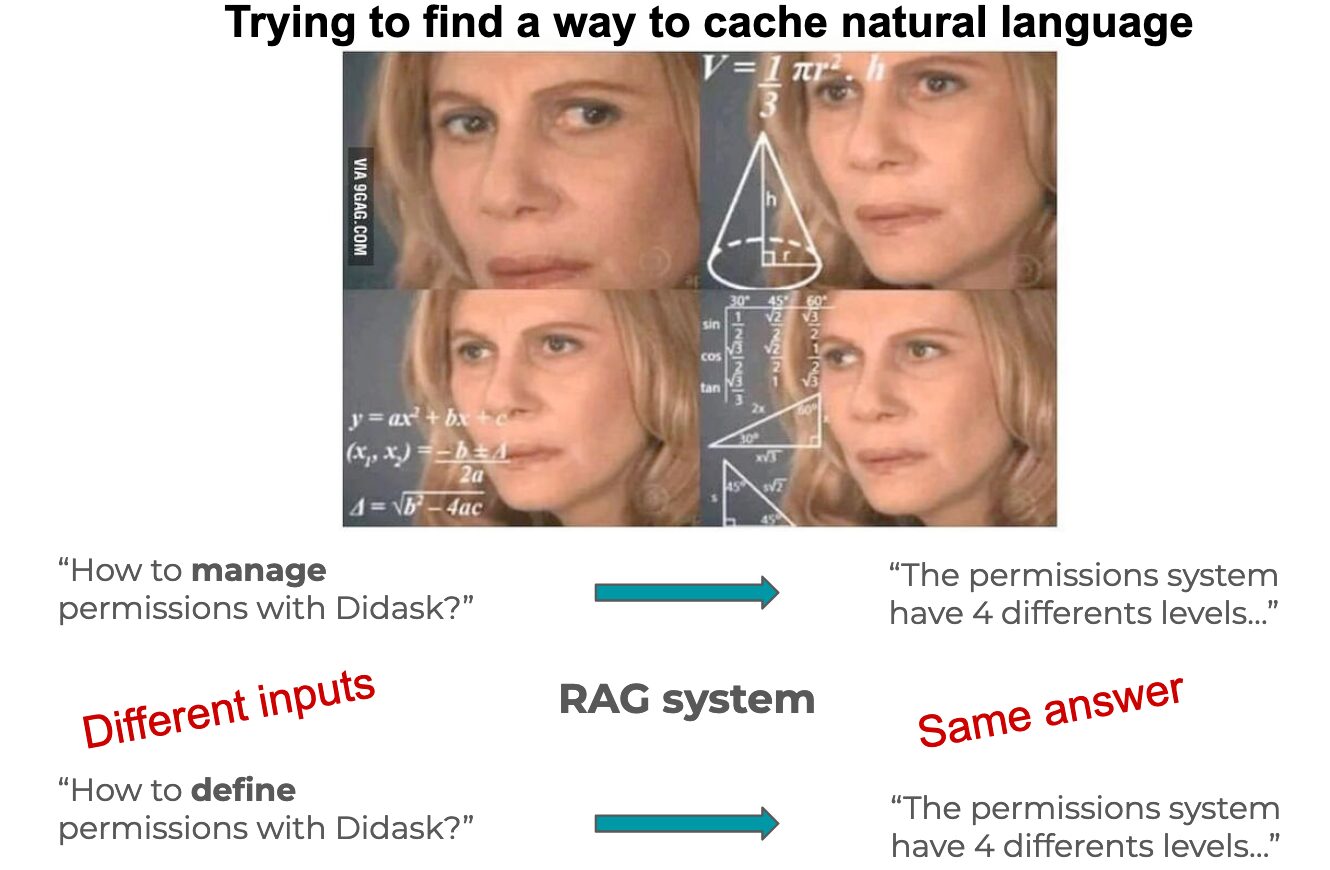

2. Spécialisation RAG simple

La “Retrieval-Augmented Generation” (RAG) consiste à fournir au LLM des informations contextuelles supplémentaires à la volée pour guider sa réponse. Ces informations sont stockées en externe (base documentaire, knowledge base, etc.) et injectées dans le prompt.

Voir aussi l’article « Bases de données vectorielles: chronique d’une mort annoncée« .

L’idée est de ne pas toucher aux poids du LLM, mais de composer des prompts capables d’encadrer et d’orienter ses réponses. Dans la pratique, un système back-end effectue une recherche (par ex. via un moteur sémantique) pour sélectionner des documents ou des extraits pertinents liés à la question. Ces extraits sont alors injectés au LLM à l’intérieur d’un prompt contextuel.

Concrètement, quand l’utilisateur pose une question spécifique, une étape de “recherche” va sélectionner les meilleurs documents correspondants à cette requête. Le LLM reçoit ensuite la question et ces documents en contexte, ce qui améliore la qualité de sa réponse.

POUR

- Cette solution s’adapte à la plupart des cas d’usage, particulièrement pour la phase de prototypage.

- Elle permet d’augmenter le champ de connaissance du LLM en s’appuyant sur des données mises à jour ou spécialisées, sans avoir besoin de fine-tuning.

- Elle reste relativement simple à mettre en place et à maintenir.

CONTRE

- La logique est en grande partie déléguée au back-end, qui structure le prompt et oriente le type de réponse attendue.

- Cette approche peut rapidement atteindre ses limites : on obtient parfois des réponses très “patternées” ou trop dépendantes de la logique du moteur de recherche externe. L’agent peut alors avoir un comportement qui semble plus “machine” que réellement conversationnel et autonome.

3. RAG avec spécialisation en graphe

Ici, on complexifie la logique en introduisant des mécanismes de sélection avancée des contextes et des instructions.

Dans un RAG spécialisé en graphe, le back-end ne se contente plus d’un simple “prompt” enrichi. Il utilise une “logique en graphe” (ou tout autre système de workflow avancé) pour naviguer dans l’historique de la conversation, choisir le type de prompt le plus adapté (par exemple : “répondre à une question”, “chercher une référence technique”, “extraire des données structurées”, etc.) et injecter le contexte approprié. Les transitions entre différents modes de raisonnement sont gérées dynamiquement au fil de la conversation, rendant l’agent plus flexible et plus sophistiqué.

POUR

- En complexifiant la logique de récupération et de génération, on confère à l’agent un comportement plus élaboré, mieux adapté à des scénarios conversationnels complexes.

- Cette approche dépasse les limites d’un simple “prompt augmenté” : on peut par exemple incorporer des règles métier, des workflows orientés tâche, etc.

CONTRE

- La complexité de mise en place et de maintenance s’accroît rapidement. Il faut concevoir et maintenir un “graphe” (ou tout autre système de routage) de prompts, ce qui peut devenir un projet en soi.

- Les coûts de développement et d’infrastructure augmentent, car on doit gérer une logique métier avancée et maintenir la cohérence sur l’historique des interactions.

4. Fine-tuning d’un modèle existant

Il s’agit de modifier directement les poids internes du réseau de neurones d’un LLM pré-entraîné, en le ré-entraînant sur un jeu de données spécifique.

Le fine-tuning repose sur la réutilisation d’un modèle ayant déjà appris des milliers (voire des milliards) de paramètres sur une grande variété de textes. Ensuite, on l’entraîne sur un corpus plus petit et spécialisé, afin qu’il incorpore des connaissances ou une “façon de répondre” propres à un domaine précis. Cet entraînement “affine” les poids du modèle, sans pour autant détruire complètement les informations génériques qu’il contient.

POUR

- Le modèle devient capable de répondre de manière plus cohérente et concise sur les sujets spécifiques, sans qu’il soit toujours nécessaire de fournir un long contexte à chaque requête.

- On peut préserver la performance générale du LLM tout en lui injectant des connaissances plus à jour ou très spécialisées.

- Un fine-tuning bien réalisé peut considérablement améliorer la pertinence et la cohérence des réponses dans un domaine précis.

CONTRE

- L’entraînement a un coût élevé en termes de matériel (GPU, espace de stockage, etc.), d’énergie et de compétences (expertise en IA, en Data Engineering, etc.).

- Il est crucial de disposer d’un ensemble de données de qualité, raffiné et équilibré pour obtenir des résultats pertinents.

- L’évaluation et la validation nécessitent également des moyens techniques et un savoir-faire important, notamment pour mettre en place des infrastructures de test adéquates.

- Il est impossible de “désapprendre” quelque chose au modèle. Par exemple, si une donnée change (comme un prix), la nouvelle information cohabitera avec l’ancienne dans les poids ré-entrainés

5. Création d’un nouveau modèle LLM

Ici, on démarre un entraînement “from scratch” (ou à partir d’un modèle très peu entraîné), au lieu de fine-tuner un modèle existant.

Cette approche consiste à entraîner un LLM entièrement nouveau, en partant d’un jeu de données spécifique. On n’hérite pas de la connaissance contenue dans un modèle générique, ou bien on ne conserve qu’un petit sous-ensemble de paramètres de base. L’objectif est de façonner un modèle hautement spécialisé, dont toute la connaissance (ou presque) provient de données du domaine cible.

POUR

- Le modèle peut être véritablement conçu et dimensionné pour le domaine visé, avec une architecture optimisée pour des tâches ou des volumes de données spécifiques.

- Cela offre une maîtrise totale sur les données et le processus d’entraînement, assurant une autonomie complète (pas de dépendance à un modèle tiers).

- On peut imaginer des cas d’usage ultra-spécialisés (confidentiels ou critiques) qui requièrent le contrôle complet sur la chaîne d’entraînement (sécurité, propriété intellectuelle, etc.).

CONTRE

- C’est l’option la plus coûteuse et la plus complexe : il faut un jeu de données considérable, des ressources de calcul substantielles et un savoir-faire technique de haut niveau pour entraîner un modèle de A à Z.

- Le risque de se retrouver avec un modèle sous-performant hors de son domaine est élevé.

- On ne bénéficie pas des connaissances “génériques” qu’un LLM pré-entraîné possède déjà, ce qui nécessite potentiellement beaucoup d’exemples pour que le modèle apprenne les subtilités du langage en plus du contenu métier.

Conclusion

En définitive, la décision de spécialiser ou non un LLM dépend de nombreux facteurs : le domaine d’application, l’ampleur du dataset disponible, le budget et les ressources techniques, la sensibilité des données, et bien sûr les objectifs de performance.

- Le LLM générique “sans spécialisation” conviendra aux besoins les plus simples ou prototypes rapides.

- Le RAG (simple ou en graphe) permettra de combiner la puissance d’un LLM générique avec des informations actualisées, tout en restant flexible et modulable.

- Le fine-tuning d’un modèle existant est une solution intermédiaire puissante, mais plus exigeante.

- La création d’un nouveau modèle est la voie la plus coûteuse et la plus complexe, mais potentiellement la plus autonome et la plus précise si l’on dispose des ressources nécessaires.

Au final, il n’existe pas de solution unique supérieure à toutes les autres. Il s’agit plutôt de trouver l’équilibre entre la performance, la spécialisation, la rapidité de mise en œuvre et le coût. Dans beaucoup de cas, démarrer avec du RAG simple, puis monter en sophistication (ou en entraînement) au fur et à mesure que le besoin l’exige, reste la démarche la plus pragmatique.

En somme, “Entraîner ou ne pas entraîner ? Telle est la question.”, et la réponse sera avant tout guidée par votre cas d’usage concret, vos ressources et vos contraintes de projet.