Ceux qui font couler de l’encre sur l’authenticité de la vidéo de Google sur les performances multimodales de Gemini ou ses performances par rapport à GPT4 passent à côté de la véritable révolution des annonces de Google.

Le marché est aujourd’hui dominé par des gros (très gros) LLM. De Mistral à GPT4, en passant par LlaMa 2, tous ces modèles dont les performances sont régulièrement confrontées aux différents benchmarks ne sont pas adaptés pour fonctionner correctement sur des smartphones.

Or, le modèle Gemini de Google propose également une version Gemini Nano avec 1.8 ou 3.25 milliards de paramètres conçue pour fonctionner sur les terminaux Android. (Pour rappel, Mistral 7B ou LlaMa 2 proposent des versions à 7 milliards au minimum.)

Ce qu’il faut bien comprendre ici c’est le changement de paradigme des capacités en IA Génératives qui étaient pour le moment réservées au cloud et qui sont maintenant accessibles directement dans les terminaux mobiles.

Gemini Nano, petit modèle et haute performances

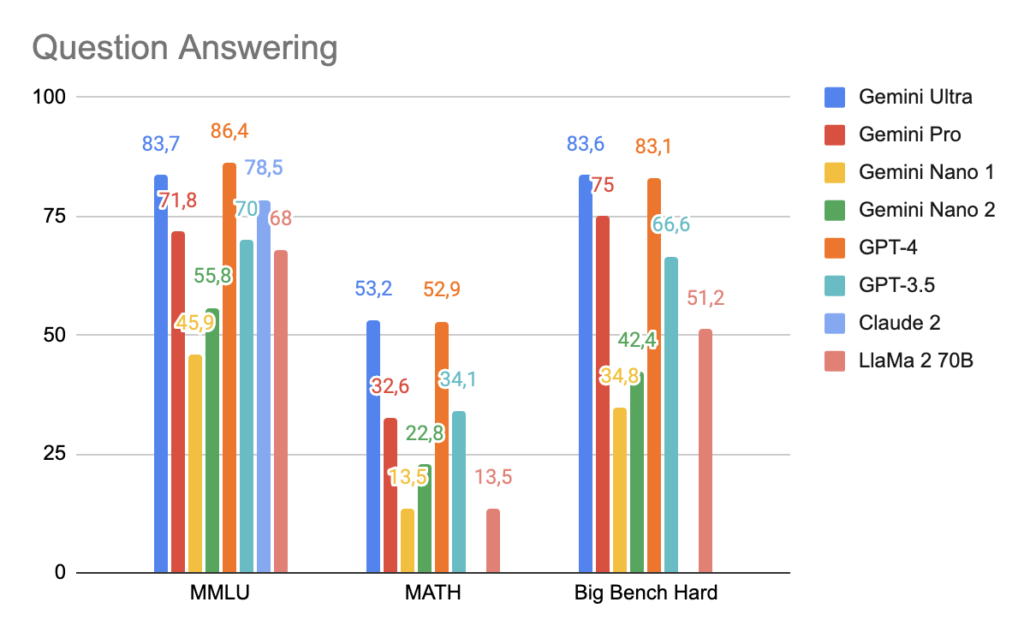

Comparons les capacités de Gemini Nano sur différentes tâches en gardant bien en tête qu’il est capable de fonctionner suffisamment rapidement sur un smartphone alors que les autres nécessitent de gros GPU pour atteindre une latence d’inférence correcte.

Sur les tâches de question et de raisonnement, les modèles Gemini Nano restent moins précis que leurs grands frères.

Les performances des modèles Nano sont en deçà des autres modèles car ils sont plus petits. Néanmoins les performances de Gemini Nano 2 (3.25B) sont seulement 10 poins en dessous de LlaMa 2, voir le surpasse alors que ce dernier est 20x plus gros!

Pour comprendre la véritable valeur des modèles Gemini Nano, il faut se rendre du côté des tâches de traduction, de compréhension d’image et de reconnaissance vocale.

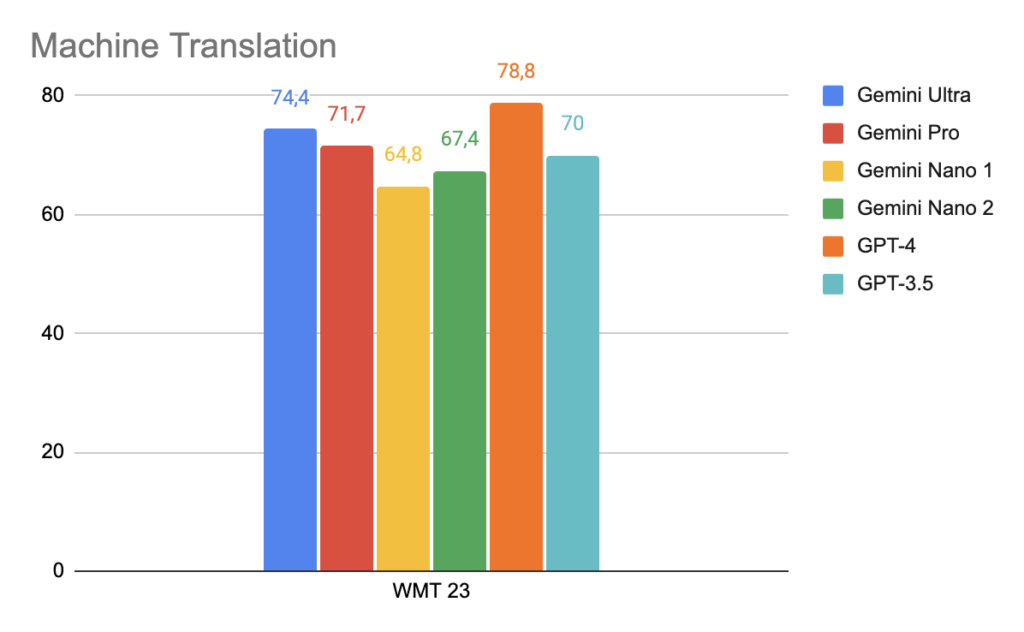

Traduction Automatisé

En traduction multilingue, les modèles Gemini Nano ne sont que 10 points derrière GPT-4.

Sachant que les smartphones sont déjà beaucoup utilisés comme des traducteur, la possibilité d’avoir un modèle capable de traduire localement va améliorer la latence et surtout réduire les factures de Cloud !

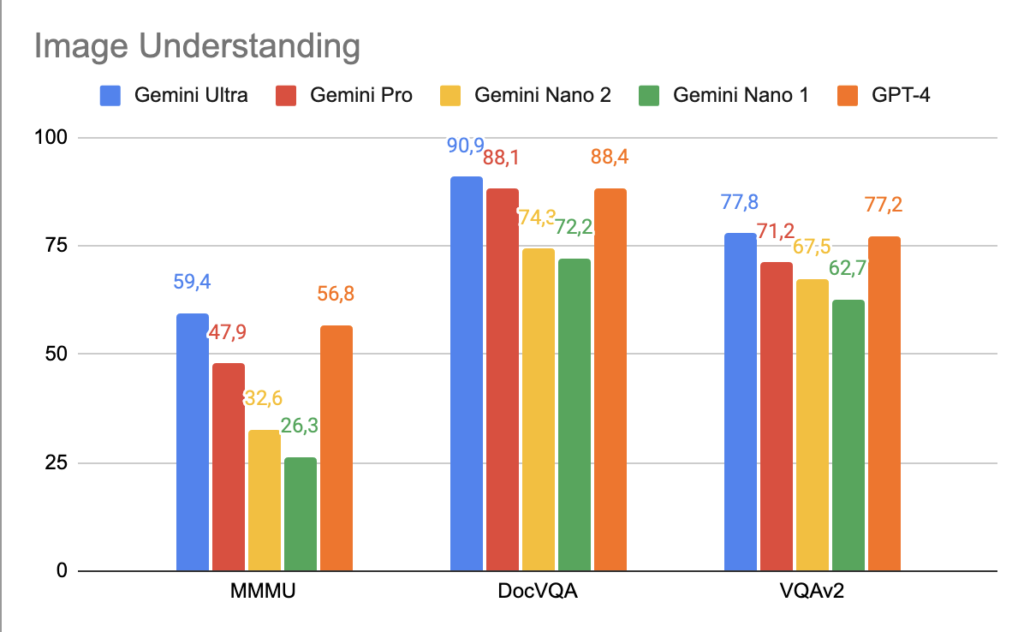

Compréhension d’image

La capacités de compréhension d’image des modèles Gemini Nano ne sont en moyenne que 10 points derrières les autres modèles.

Les possibilités offertes par la compréhension d’image directement sur smartphone vont permettre d’ouvrir toute une nouvelle gamme d’applications.

On pense notamment à des applications comme Be Me Eyes qui aide les personnes malvoyantes en décrivant les objets qu’elles prennent en photo.

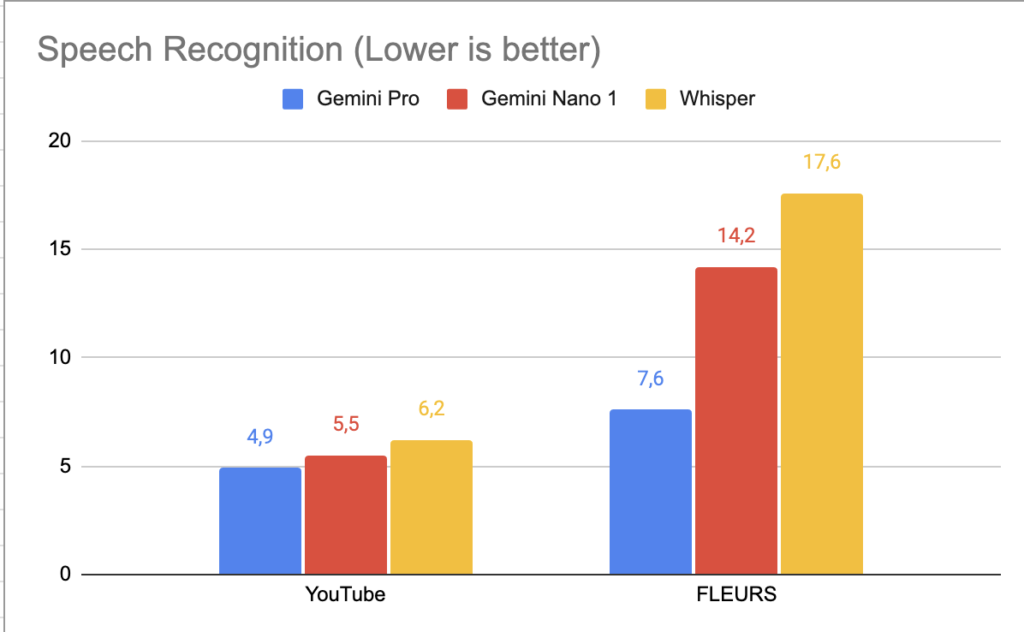

Reconnaissance vocale

Sur la reconnaissance vocale, Gemini Nano fait même mieux que la dernière version de Whisper qui était le meilleur modèle jusqu’à présent.

Conclusion

Les modèles Gemini Nano sont la véritable révolution dans le monde de la GenAI qui était jusqu’à maintenant dominé par de très gros modèles taillés pour le Cloud.

Avec leurs 32 000 tokens de contexte et leurs possibilités multimodales, les modèles de la famille Gemini sont une innovation indiscutable.

C’est toute une nouvelle gamme d’application qui va être rendue possible dès le mois de décembre car un déploiement de Gemini Nano est prévu sur les smartphones Google Pixel 8.

Ici encore c’est une innovation qui va profiter à l’écosystème Android pendant que Apple reste pour l’instant loin derrière les innovations en Generative AI.

Les sources des graphiques sont disponibles dans l’article technique de Gemini