Les outils de génération d’images sont basés sur une architecture de réseau de neurone appelée “Transformers”.

Ils fonctionnement également avec des prompts décrivant les images souhaitées. Contrairement aux Large-Language-Models, les modèles de génération d’images ont une compréhension beaucoup moins approfondi des subtilités de la langue.

Ces modèles ont plusieurs types d’utilisation.

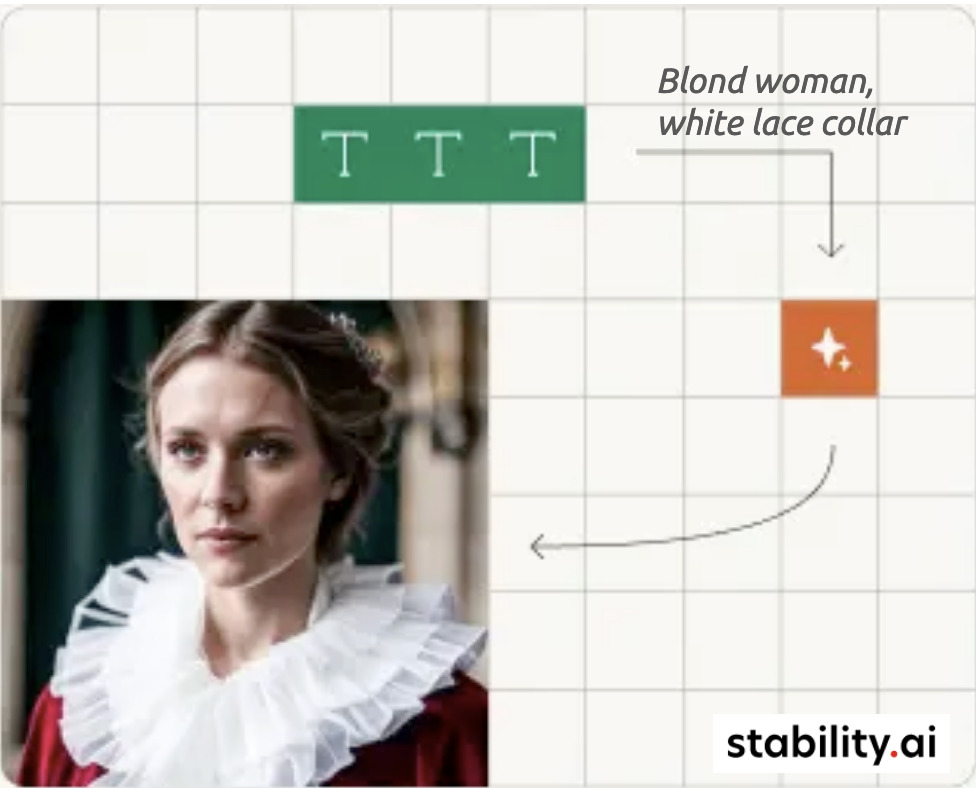

Text-to-image

Une description donnée au modèle permet la génération d’une image.

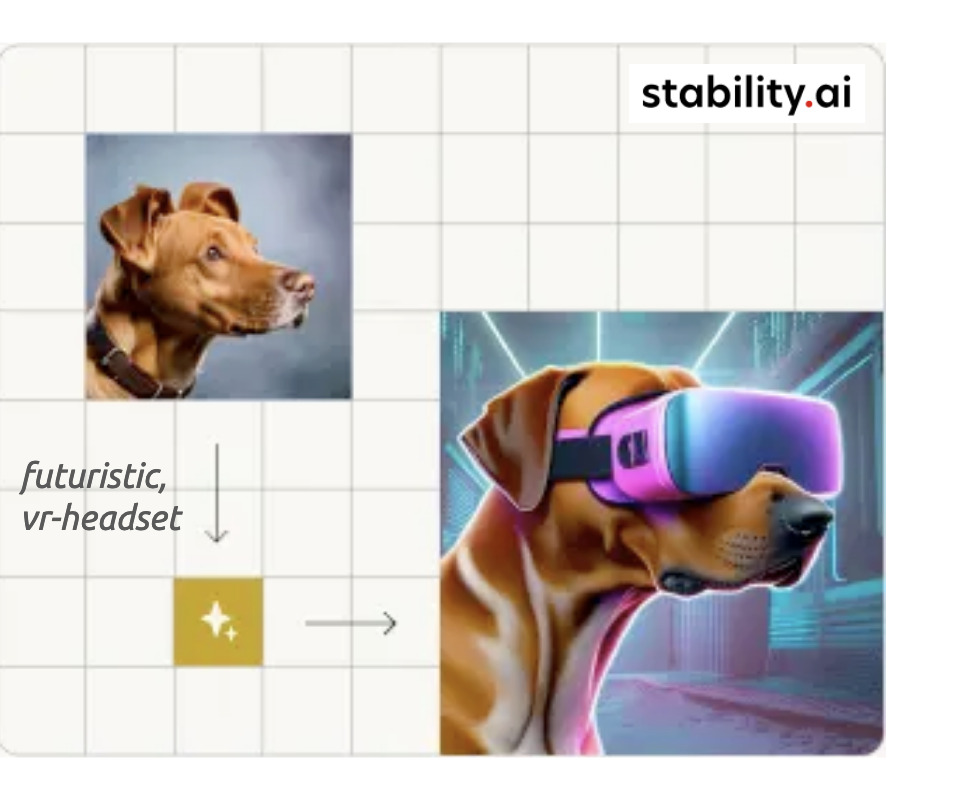

Image-to-image

Une image de base est modifiée par la description du prompt.

Upscaling

Cette technique permet d’améliorer la qualité d’une image.

C’est notamment très utile après un zoom sur une partie d’une image quand la qualité visuelle a été dégradé.

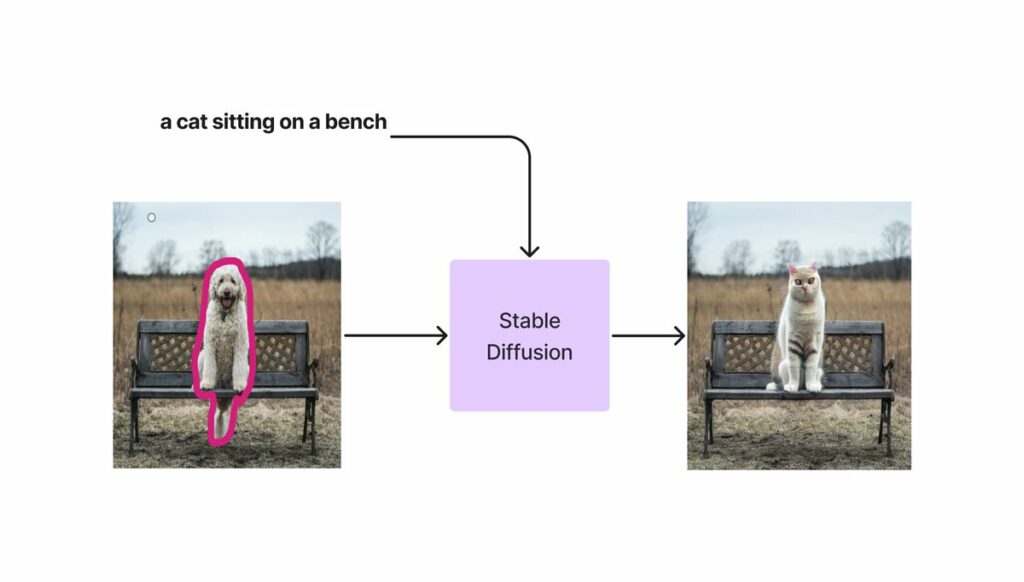

Inpainting

Un détail d’une image est modifié en fonction du prompt.

C’est très utile pour les retouches.

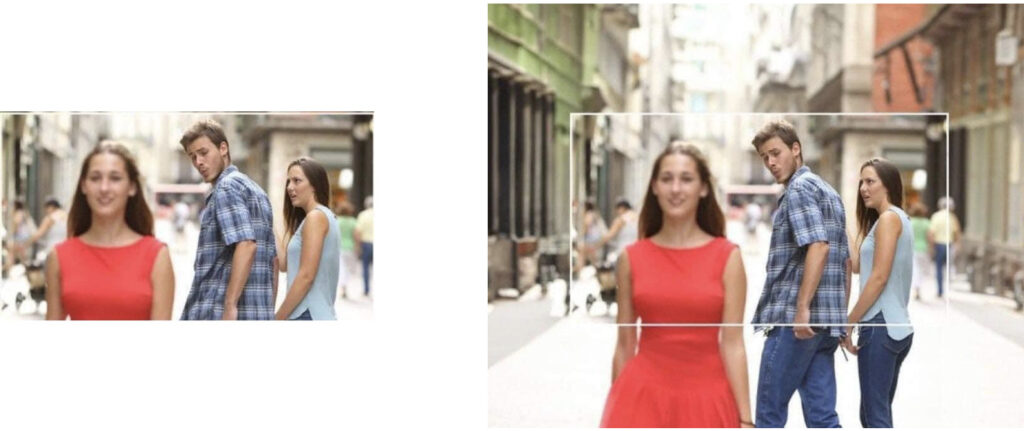

Outpainting

Dans cette technique, le modèle va imaginer ce que pourrait être la suite d’une image.

Stable Diffusion

Ce modèle est développé par StabilityAI et est disponible en Open Source.

C’est le plus populaire de part la taille de sa communauté et ses nombreuses extensions.

Il est disponible en local, en application web et en API.

Découvrir 👉 Notre guide Stable Diffusion

Midjourney

Midjourney est un modèle 100% propriétaire disponible uniquement au travers d’un bot Discord.

Les créations de Midjourney sont très appréciées car le niveau de réalisme et de détails y est généralement plus élevé que pour Stable Diffusion.

Découvrir 👉 Notre guide Midjourney

Dall-E 3

Dall-E 3 est la troisième version (you don’t say!) du modèle Dall-E de OpenAI.

L’outil est intégré à l’interface web de ChatGPT et tire pleinement partie du haut niveau de compréhension du langage des LLM d’OpenAI, ce qui permet de générer des images très précises.

Découvrir 👉 Notre guide Dall-E 3